- Énergie

L’entraînement et l’utilisation de ChatGPT consomment beaucoup d’énergie, mais les chiffres exacts sont difficiles à déterminer sans les données d’OpenAI

Alors que les capacités et l’adoption de l’intelligence artificielle (IA) augmentent rapidement, certaines personnes ont commencé à examiner de près ses coûts environnementaux. Sur les médias sociaux, des utilisateurs ont comparé les besoins en énergie des robots de conversation d’IA (comme ChatGPT) à d’autres activités de nos vies quotidiennes.

Par exemple, un post Linkedin du 15 février 2025 affirme que « Dix conversations par jour avec ChatGPT-4, c’est une tonne de CO2 par an. L’équivalent d’un Paris-New York en avion. » La source de cette information semble être un article paru sur Vert – un média français indépendant – le 21 novembre 2024.

Ci-dessous, nous allons enquêter sur ce type d’affirmation et nous pencher sur certains aspects connus et inconnus de la consommation d’énergie des robots de conversation d’IA tels que ChatGPT.

À RETENIR :

L’impact de l’intelligence artificielle (IA) sur l’énergie augmente à mesure que ses capacités et usages se développent. L’entraînement et l’utilisation des modèles d’IA nécessitent beaucoup d’énergie en raison de l’utilisation de centres de données – l’une des infrastructures les plus énergivores.

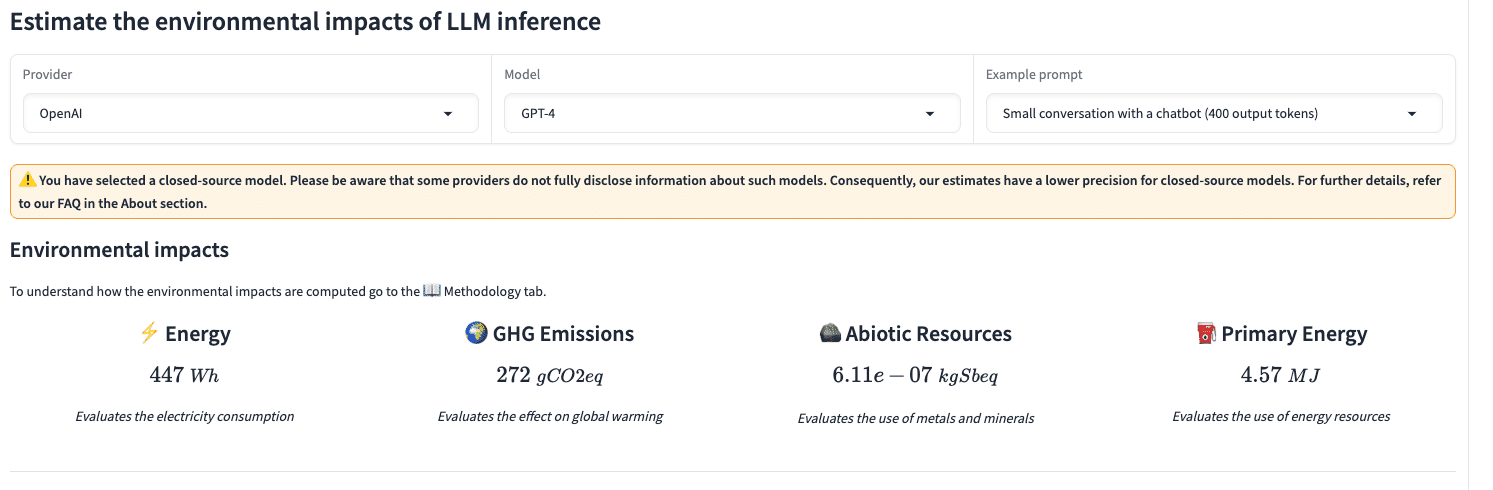

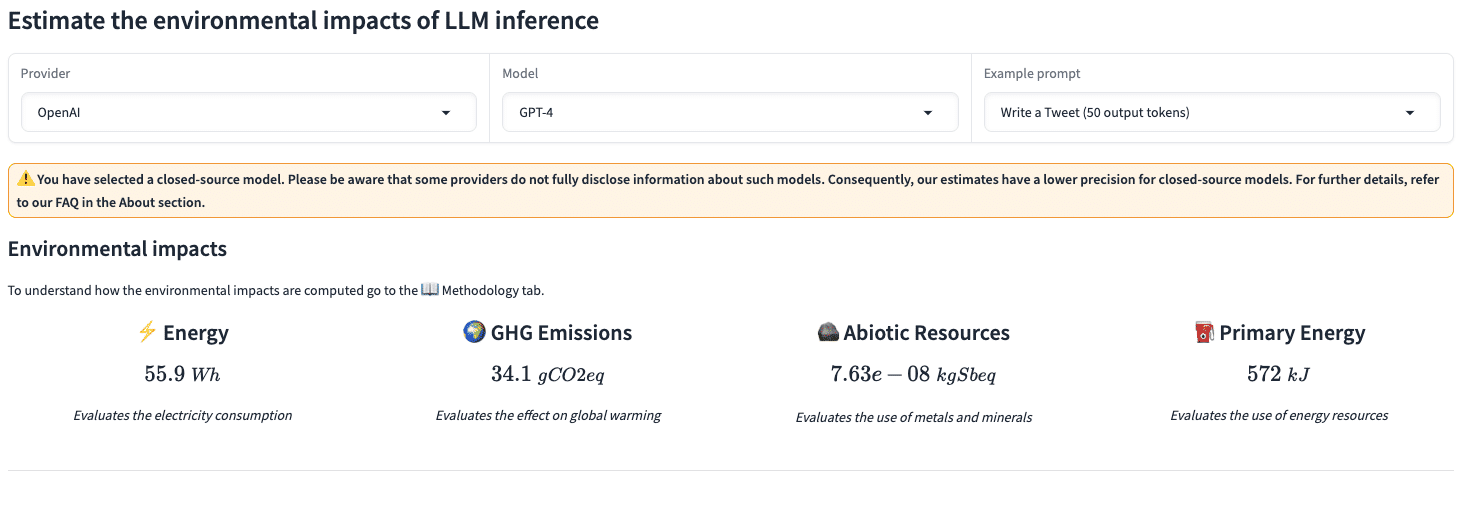

Bien que cette consommation d’énergie soit largement connue, OpenAI – l’entreprise ayant créé ChatGPT – n’a pas publié suffisamment de données pour que l’on sache exactement quelle quantité d’énergie est consommée lors de l’utilisation de ses robots conversationnels (comme GPT-4). Un outil en ligne appelé « EcoLogits » permet d’estimer la consommation d’énergie et les émissions de CO2 liées à l’utilisation de ChatGPT, mais sa précision est limitée en raison du manque de données d’OpenAI.

L’outil EcoLogits calcule les émissions tout au long de la chaîne de valeur : l’extraction des matières premières, le transport, l’utilisation et la fin de vie. Bien qu’il s’agisse d’une méthode valable, il peut être trompeur de comparer ces résultats aux émissions des vols (comme cela a été fait dans un récent message sur les médias sociaux). Ces dernières sont plus directes : le carburant est brûlé, le CO2 est émis. Cela exclut d’autres étapes nécessaires pour qu’un avion vole, telles que la construction de l’avion et le transport du carburant, qui augmenteraient l’empreinte carbone si elles étaient incluses.

D’IMPORTANTES QUANTITÉS D’ÉNERGIE SONT NÉCESSAIRES POUR L’ENTRAÎNEMENT ET L’UTILISATION DE CHATGPT – LA CONSOMMATION D’ÉNERGIE DE L’IA DEVRAIT AUGMENTER

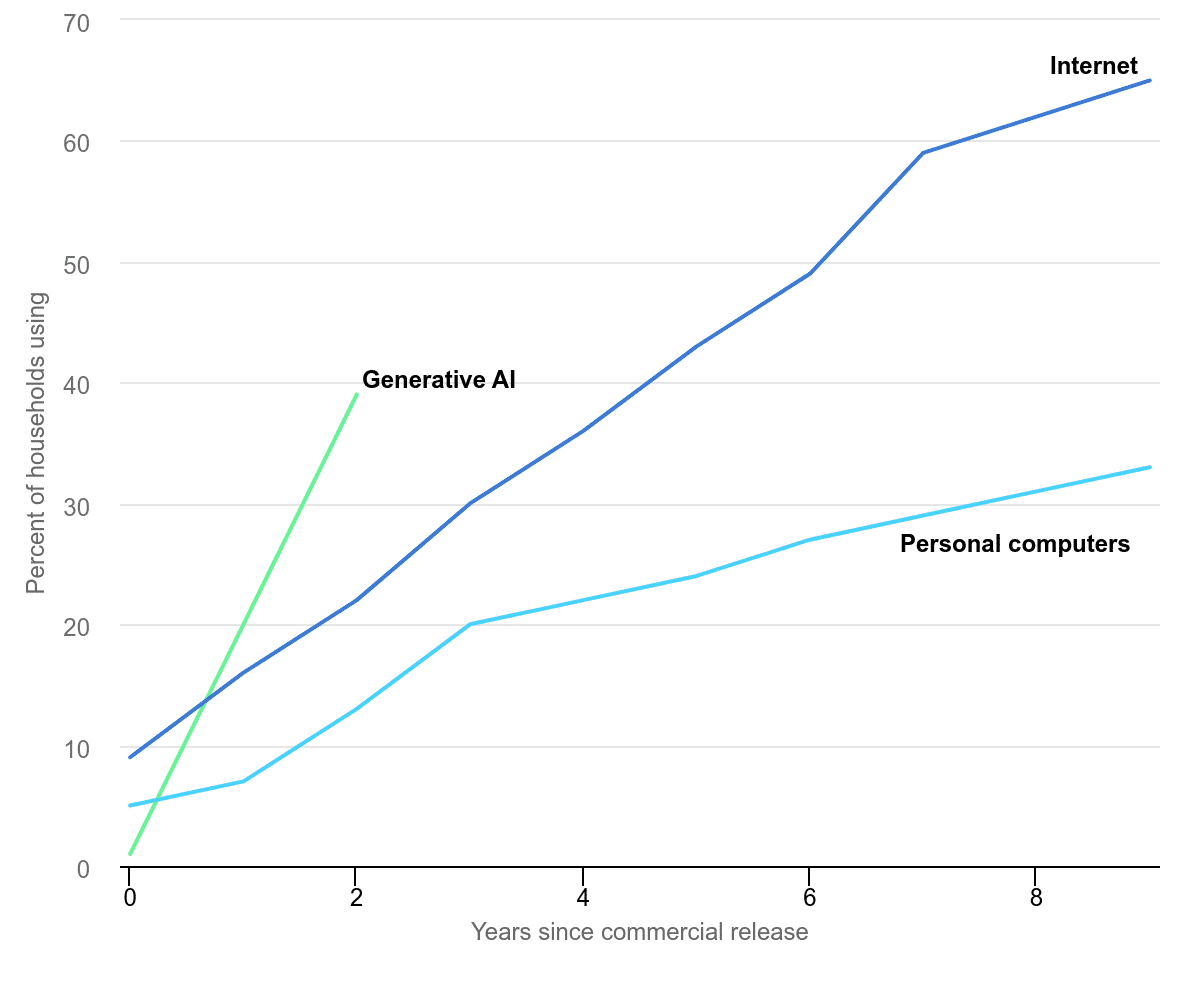

Pourquoi étudier la consommation d’énergie de ChatGPT ? L’entraînement et l’utilisation de modèles d’intelligence artificielle consomment d’importantes quantités d’énergie en utilisant des centres de données – l’une des infrastructures les plus énergivores selon le Ministère américain de l’énergie. Sans compter que l’utilisation de ces technologies est en pleine expansion. Selon l’Agence internationale de l’énergie (AIE), lorsque l’on compare la part des ménages ayant adopté des technologies après leur commercialisation, le taux d’adoption de l’IA générative a dépassé celui des ordinateurs personnels et d’internet (figure 1).

Quelles en sont les conséquences sur la consommation d’énergie ? Bien que ce soit un sujet de recherche en cours, l’AIE explique que « la consommation d’électricité des centres de données, de l’intelligence artificielle (IA) et du secteur des crypto-monnaies pourrait doubler d’ici 2026 ». Cette consommation d’électricité combinée correspondrait à peu près à celle du Japon. Mais qu’en est-il spécifiquement de l’IA ?

L’augmentation du nombre d’utilisateurs et des capacités des robots conversationnels d’IA s’accompagne d’inquiétudes concernant la consommation d’énergie. Cela a été souligné par Vijay Gadepally, chercheur au Lincoln Laboratory du Massachusetts Institute of Technology (MIT), dans un article de janvier 2025 publié par la Sloan School of Management du MIT :

« Avec le passage du texte à la vidéo et à l’image, ces modèles d’IA deviennent de plus en plus gros, tout comme leur impact énergétique […] Cela va se traduire par une consommation d’énergie assez importante et une contribution croissante aux émissions dans le monde entier. »

À grande échelle, il est clair que les progrès et l’utilisation de l’IA ont un impact sur l’énergie et l’environnement. Mais en savons-nous assez pour calculer l’énergie exacte utilisée ou le dioxyde de carbone (CO2) émis par requête à ChatGPT – ou GPT-4 plus précisément ? Pour l’instant, il est assez difficile de répondre à cette question.

De nombreux messages sur les médias sociaux évoquent l’énergie nécessaire aux requêtes à ChatGPT, mais peu d’entre eux citent des sources pour cette information. Et il y a peut-être une bonne raison à cela : il semble y avoir une pénurie de données, tant de la part de l’entreprise qui a développé le modèle (OpenAI) que dans la littérature scientifique.

Par conséquent, certains ont tenté de l’estimer eux-mêmes en utilisant des valeurs approximatives. Par exemple, l’affirmation que nous avons mentionnée plus haut – comparant les émissions potentielles de CO2 de l’utilisation quotidienne de GPT-4 et d’un vol transatlantique – a utilisé un outil appelé « EcoLogits Calculator ». Le post Linkedin faisant cette affirmation relate un article de Vert publié le 21 novembre 2024, qui détaillait certaines hypothèses sous-jacentes.

Pour vérifier s’il s’agit d’une comparaison exacte, Science Feedback a cherché à répondre à quelques questions : ont-ils utilisé une bonne méthodologie, pouvons-nous reproduire leur travail pour obtenir les mêmes valeurs, et y a-t-il des incertitudes ?

LES ÉMISSIONS DES REQUÊTES ADRESSÉES À CHATGPT NE PEUVENT ÊTRE ESTIMÉES QUE DE MANIÈRE APPROXIMATIVE EN RAISON D’IMPORTANTES LACUNES DANS LES DONNÉES

Avant de nous pencher sur la question, il convient de noter que l’article de Linkedin ajoutait une mise en garde indiquant que leurs calculs étaient « imparfaits » en raison du manque de données d’OpenAI à ce sujet. Cependant, ces avertissements peuvent facilement être oubliés ou laissés de côté lorsque les gens décident de partager l’affirmation simplifiée comparant l’utilisation de ChatGPT à un vol transatlantique.

Si les gens n’entendent ou ne lisent que l’affirmation elle-même, est-elle exacte ? Comme nous le détaillons ci-dessous, il y a plusieurs raisons pour lesquelles l’allégation seule pourrait être trompeuse.

Pour commencer l’enquête, Science Feedback a d’abord tenté de reproduire les valeurs de l’outil « EcoLogits » utilisé pour calculer les émissions de gaz à effet de serre et la consommation d’énergie. En suivant les hypothèses énoncées dans l’article de Vert, Science Feedback est parvenu aux mêmes valeurs que celles mentionnées dans l’article (figure 2). Cependant, la question demeure : dans quelle mesure ces valeurs sont-elles proches de la réalité ?

Une note dans l’outil lui-même explique qu’en sélectionnant un modèle à source fermée comme GPT-4, les estimations d’EcoLogits auront une précision plus faible – ce qui confirme le problème que nous avons mentionné concernant la rareté des données. Pour en savoir plus, Science Feedback a contacté Anne-Laure Ligozat, professeure d’informatique à l’ENSIIE et au LISN, qui étudie les impacts environnementaux du numérique.

« L’outil Ecologits utilisé ici est basé sur une méthodologie solide, mais comme vous l’avez souligné, les données nécessaires ne sont pas toujours disponibles et le calcul des impacts nécessite donc de faire quelques hypothèses et approximations. L’ordre de grandeur obtenu est cohérent avec les publications scientifiques [voir ici et ici, par exemple] », explique Ligozat.

Cependant, bien que l’ordre de grandeur de ces valeurs soit cohérent avec d’autres recherches – ce qui signifie que les valeurs ne sont pas 10 fois plus grandes ou plus petites – il subsiste des incertitudes. Ligozat poursuit : « L’incertitude est élevée en raison de ces approximations, mais je ne pense pas que des valeurs d’incertitude soient disponibles pour cet outil. »

Interrogée sur la précision et les incertitudes liées à l’affirmation en question (c’est-à-dire la comparaison avec les vols transatlantiques), Ligozat a détaillé : « Cela donne probablement un ordre de grandeur correct, mais multiplier les impacts pour une seule inférence n’est peut-être pas la meilleure façon d’estimer les impacts globaux, en particulier parce que cela masque les effets de seuil. »

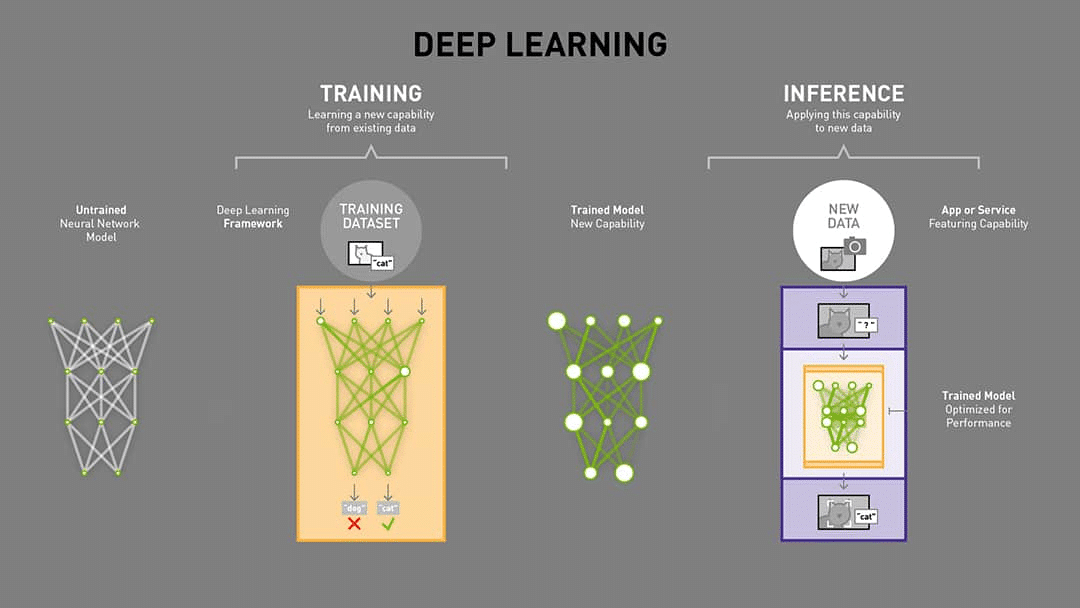

Pour ceux qui ne sont pas familiers avec ces termes, décryptons-les rapidement. Une inférence est le processus par lequel un utilisateur envoie une requête à un modèle d’IA entraîné, qui se base ensuite sur son apprentissage (« training » sur la figure 3) pour trouver une réponse pour l’utilisateur (figure 3).

Dans la citation ci-dessus, Ligozat souligne que l’affirmation simplifie potentiellement un scénario plus complexe en utilisant l’outil EcoLogits pour calculer les émissions et la consommation d’énergie à partir d’une inférence (requête) et en la multipliant (par exemple, 10 fois par jour multiplié par 365 jours par an). En d’autres termes, un scénario d’émissions unique (comme une seule conversation sur ChatGPT) ne peut pas nécessairement être mis à l’échelle en le multipliant. Comme l’explique Ligozat :

« L’impact de l’exécution de plusieurs inférences peut ne pas être un multiple de l’exécution d’une seule : par exemple, si vous ne traitez que quelques inférences par jour, un petit serveur de base peut suffire, alors que si vous en traitez des milliers par jour, un serveur de calcul avec des caractéristiques différentes sera nécessaire.

Je ne suis pas sûre si cela sous-estime ou surestime les impacts car les changements peuvent aller dans les deux sens : par exemple, les impacts de fabrication d’un serveur plus grand peuvent être significativement plus élevés (augmentation de l’empreinte), mais il peut [traiter] une inférence beaucoup plus efficacement (diminution de l’empreinte). »

Entre le manque de données d’OpenAI, la précision moindre qui en résulte dans les estimations d’EcoLogits et la méthode utilisée dans le post Linkedin en « multipliant » les effets sur plusieurs jours et années, il semble que plusieurs niveaux d’incertitude soient compris dans l’affirmation comparant les requêtes ChatGPT aux émissions des vols.

Il convient également de noter que la méthode de calcul des émissions de CO2 par requête dans l’outil EcoLogits est basée sur une méthodologie d’analyse du cycle de vie – et pas seulement sur les émissions directes résultant de l’énergie consommée par l’utilisation de ChatGPT. En d’autres termes, alors que les émissions des vols sont directement liées au CO2 émis par litre de carburant fossile utilisé, la méthodologie d’EcoLogits prend en compte de manière plus large le CO2 émis à plusieurs étapes – extraction des matières premières, transport, utilisation et fin de vie.

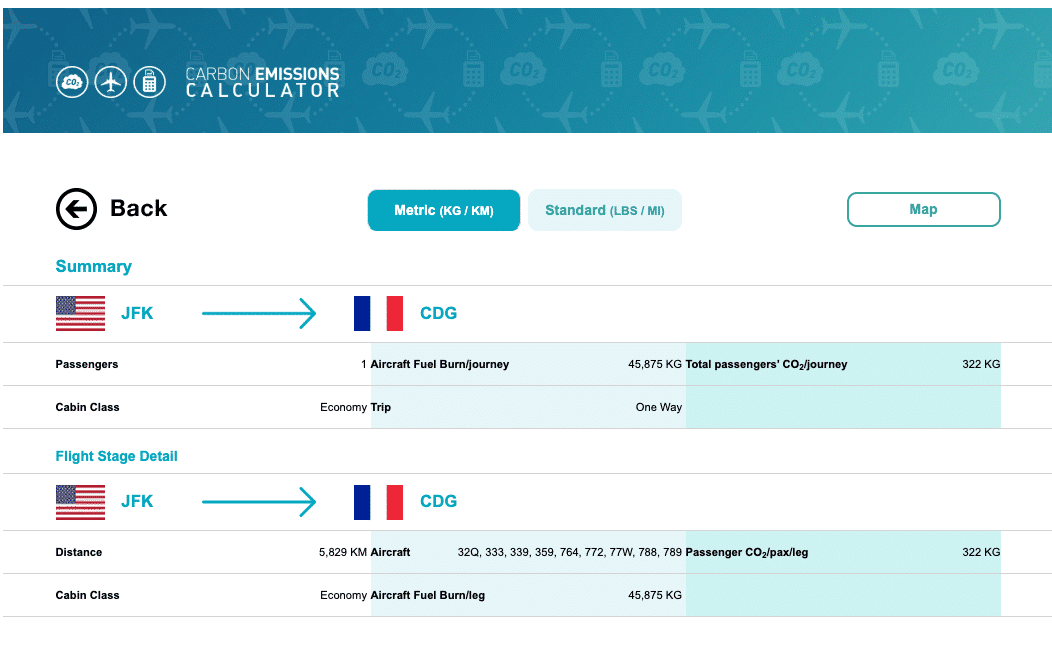

Science Feedback a également constaté des variations dans le calcul des émissions de CO2 pour un vol New York-Paris en utilisant cinq outils différents. Les valeurs allaient de 322 kg de CO2 à 1 000 kg de CO2 (environ une tonne). Toutefois, le calculateur dont la méthodologie est la plus transparente et la plus détaillée est celui de l’Organisation de l’aviation civile internationale (OACI). Il donne une valeur de 322 kg de CO2 (figure 4).

Cela représente environ un tiers des émissions de CO2 provenant des estimations de l’utilisation de ChatGPT 10 fois par jour. Mais là encore, la méthodologie de l’OACI explique qu’il ne s’agit que du CO2 provenant de la combustion du carburant, et non d’une analyse du cycle de vie complet (comme c’est le cas dans les estimations d’EcoLogits).

La comparaison faite dans le post Linkedin peut également être trompeuse parce qu’elle ne tient pas compte de la complexité de chaque type d’inférence. L’exemple cité est celui d’une « petite » conversation, mais il semble avoir été choisi arbitrairement parmi d’autres cas d’utilisation.

Par exemple, si un utilisateur de ChatGPT souhaite plutôt écrire un tweet, les émissions de CO2 (par EcoLogits) pour le même type de scénario (10 fois par jour pendant un an) passent d’environ 992 kg de CO2 par an à 124 kg, soit une différence de près de 8 fois (figure 5). Dans l’exemple du « tweet » – en utilisant le calculateur EcoLogits – les émissions seraient à peu près équivalentes à un tiers d’un vol New York-Paris (en fonction du calculateur d’émissions de vol utilisé).

En termes de consommation d’énergie, l’énergie consommée par la rédaction d’un seul tweet avec GPT-4 – selon les estimations d’EcoLogits – pourrait alimenter une ampoule à incandescence de 60 watts (une ampoule domestique standard) pendant un peu moins d’une heure. Dans la figure 5, l’énergie est exprimée en « Wh » ou « wattheures », c’est-à-dire la puissance électrique consommée pour faire fonctionner quelque chose pendant une heure (une ampoule de 60 watts peut donc fonctionner pendant un peu moins d’une heure avec 55 Wh d’énergie).

Si ce type de comparaison peut contribuer à informer les gens des impacts environnementaux potentiels de l’utilisation de technologies émergentes telles que l’IA, il peut être préjudiciable pour les lecteurs de sélectionner des exemples sans expliquer davantage le contexte ou sans être transparent sur les incertitudes en jeu. Sans ce contexte important, les gens pourraient remarquer des écarts importants dans les estimations partagées sur les médias sociaux, dévaluant une conclusion plus importante : l’IA se développe rapidement et devrait encore accroître la demande d’énergie et les émissions de gaz à effet de serre.

Science Feedback a sollicité la rédaction de Vert. L’article sera mis à jour si de plus amples informations nous sont communiquées.

Feedback des scientifiques

Questions de Science Feedback :

1- Existe-t-il un moyen d’estimer la consommation d’énergie d’une requête/recherche GPT-4 ? Les données disponibles sont-elles suffisantes pour le faire ?

2- Quel est le degré d’incertitude de ce type de calcul de la consommation d’énergie ?

3- Pensez-vous que l’affirmation ci-dessus concernant les émissions de CO2 dues à l’utilisation de GPT-4 est une approximation précise ou qu’il y a trop de lacunes dans les données ou d’incertitudes pour faire de telles déclarations (par exemple, en les comparant aux émissions dues à un vol) ?

Anne-Laure Ligozat

Professeure, LISN et ENSIIE

1. L’outil Ecologits utilisé ici repose sur une méthodologie solide, mais comme vous l’avez souligné, les données nécessaires ne sont pas toujours disponibles, le calcul des impacts nécessite donc de faire quelques hypothèses et approximations. L’ordre de grandeur obtenu est cohérent avec les publications scientifiques [voir ici et ici, par exemple].

2. L’incertitude est élevée en raison de ces approximations, mais je ne pense pas que des valeurs d’incertitude soient disponibles pour cet outil.

3. Cela donne probablement un ordre de grandeur correct, mais la multiplication des impacts pour une inférence n’est peut-être pas la meilleure façon d’estimer les impacts globaux, en particulier parce qu’elle masque les effets de seuil. L’impact de l’exécution de plusieurs inférences peut ne pas être un multiple de l’exécution d’une seule : par exemple, si vous ne traitez que quelques inférences par jour, un petit serveur de base peut suffire, alors que si vous en traitez des milliers par jour, un serveur de calcul avec des caractéristiques différentes sera nécessaire.

Je ne suis pas sûre si cela sous-estime ou surestime les impacts car les changements peuvent aller dans les deux sens : par exemple, les impacts de fabrication d’un serveur plus grand peuvent être significativement plus élevés (augmentation de l’empreinte), mais il peut [traiter] une inférence beaucoup plus efficacement (diminution de l’empreinte) ».